Вся правда об обновлении Google BERT 2020

BERT — это метод нейронной сети, цель которого — предварительная подготовка языковых представлений для задач обработки естественного языка (NLP).

Модели обрабатывают слова по отношению ко всем другим словам в предложении, а не по порядку. Таким образом, модели BERT могут учитывать полный контекст слова, рассматривая слова, которые идут до и после него, что особенно полезно для понимания цели поисковых запросов.

— Pandu Nayak, Google Fellow and Vice President, Search

История создания метода BERT

Информация о первоначальном выпуске BERT размещена на GitHub 31 октября 2018 года.

Google очень серьёзно относится к разработке программного обеспечения такого масштаба, поэтому прежде, чем выложить модель BERT в свободный доступ прошли годы разработки и тестирования.

Это просто моя гипотеза, но я думаю, что модель BERT тестировалась в рамках нескольких медицинских апдейтов Google 2018 года, а возможно и ранее — в 2017 году, когда появилась информация о некоем алгоритме “Fred” и о медицинском апдейте в рунете (сентябрь 2017 года).

В процессе обучения BERT с 31 мая 2019 года начали использовать “Модель маскировки всего слова” (Whole Word Masking). Я не буду усложнять описание техническими терминами типа токены и так далее, кому интересно, почитает по ссылкам на GitHub.

|

| В процессе обучения BERT с 31 мая 2019 года начали использовать “Модель маскировки всего слова” (Whole Word Masking). |

Буквально через месяц после внедрения в BERT модели Whole Word Masking, в июне 2019 года Google провёл широкое обновление ядра алгоритма (так называемое июньское обновление 2019 года). Весьма вероятно, что частью этого обновления был эксперимент по тестированию того, насколько точно BERT может анализировать текст, логику его изложения, естественность языка и взаимосвязи между словами.

Косвенно мою гипотезу подтверждает Pandu Nayak, Google:

Чтобы запустить эти улучшения, мы провели много тестов, чтобы убедиться, что изменения на самом деле более полезны.

И лишь 25 октября 2019 года Google официально сообщил о начале использования BERT в поиске.

Я думаю, что через две недели (с 6 – 7 ноября 2019 года) после завершения этого обновления многие вебмастера заметили значительные изменения в трафике. По моим наблюдения, это, в основном, коснулось информационных сайтов (тематики “Новости”, “Медицина”, “Эссе”).

На 19 ноября 2019 года был запланирован запуск нового Центра для издателей Google News, но что-то пошло не так и это обновление появилось в начале декабря 2019 года.

Вот что известно об этом обновлении Google News:

Google будет использовать программный подход для идентификации издателей новостей. Аналогично тому, как Google определяет и оценивает другие типы контента в Поиске, издателям не нужно будет «подавать заявку на включение», чтобы они рассматривались в Новостях Google.

Предполагаю, что одной из задач BERT является распознавание сути написанного и классификация текста по категориям, например, “Новости”, “Прогнозы”, “Советы” и так далее.

Google — это в первую очередь коммерческая компания и все новшества имеют конечную цель — максимально увеличить прибыль, в том числе путём снижения расходов. Те из вас, которые подавали заявки в Google News знают, что качество сайтов проверяли так называемые ревьюверы. Это сотрудники сторонних агентств, чьи услуги стояли для Google очень дорого. Внедрение BERT поможет Google полностью или частично отказаться от этих услуг.

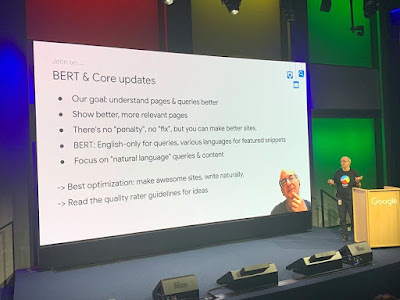

Как повлияет Google BERT на SEO?

Думаю, именно это в первую очередь интересует вебмастеров и интернет-маркетологов.

BERT даст возможность Google лучше понимать смысл текста. При этом акцент делается на естественность языка.

Внедрение BERT повлияет на оценку релевантности, ранжирование, трафик, отображение сниппетов и на показ страниц сайта в Google News, Google Discover.

По логике вещей, если с помощью BERT Google будет лучше понимать смысл написанного (контекст), то это значит, что Google Panda будет получать более точную информацию.

BERT также учится моделировать отношения между предложениями, выполняя предварительную подготовку по очень простой задаче, которая может быть сгенерирована из любого текстового корпуса: если даны два предложения A и B , является ли B фактическим следующим предложением, которое следует после A в корпусе, или просто случайное предложение.– Jacob Devlin and Ming-Wei Chang, Research Scientists, Google AI Language

Рассмотрим простой пример. Открываем страницу сайта, на которой основной текст — информация о жизни Достоевского, а внизу традиционный “постовой” — “…смотрите что-то там онлайн…”

BERT даст сигнал Google Panda и, возможно, алгоритму Пингвин, и, в итоге, пострадают оба сайта.

SEO рекомендации в условиях применения BERT

Текст должен быть написан максимально просто, кратко, грамотно и естественно. Этого требуют Федеральные руководящие принципы простого языка. Это закон США и Google его беспрекословно выполняет и учитывает в работе своих алгоритмов, особенно это касается текстов на английском языке.

Избегайте жаргона, минимизируйте сокращения и определения. Используйте одни и те же термины последовательно. Будьте лаконичны.

Текст должен быть оригинальным, слова и фразы в нём должны логически дополнять друг друга и нести полезную смысловую нагрузку.

Для того чтобы BERT лучше понимал вашу логику изложения (контекст) и не воспринял какие-то предложения как случайные, используйте слова – соединители: “Как сказано выше”, “Поэтому” и так далее. Вы должны показать, что каждое следующее предложение логически уместно.

Откажитесь от устаревшей практики размещения “постовых” (внизу статьи) в нетематических по содержанию текстах.

Если вы занимаетесь покупкой (размещением) ссылок, старайтесь размещать их внутри текстов, которые релевантны вашей ссылке и в которых ваша ссылка выглядит логично и естественно.

В завершение, если вы хотите протестировать, как работает “Модель маскировки всего слова”, попробуйте бесплатный инструмент Института Аллена (The Allen Institute for Artificial Intelligence). Инструмент поддерживает только английский язык.